【図解】ニューラルネットワークの活性化関数とは?【連載③】

どうもあつかんです。

今回はニューラルネットワークに使用される活性化関数について説明していこうと思います。

ゼロから作るDeep Learningという本を参考にさせていただいております。

また、このブログは連載形式ですので下の記事を読んでから読むことおすすめします。

活性化関数とは?

活性化関数については

【初心者向け】ニューラルネットワークとは?【連載②】 - IT-LIFEブログ

で簡単な説明がしてありますが、ここでも少し説明しようと思います。

活性化関数とは入力信号の総和をどのように活性化(発火)させるを決定する役割があります。

活性化関数にも複数の種類があり、ステップ関数、シグモイド関数、ReLU関数というものがあります。

過去記事からわかるようにパーセプトロンでは活性化関数としてステップ関数が使われていましたね。

ステップ関数とは下図のように閾値を超えていたら1を出力、閾値を超えていなかったら0を出力するような関数でした。

ここで質問です。

パーセプトロンをニューラルネットワークの世界に拡張させるためにはどうしたらよいでしょうか?

答えは、パーセプトロンで使われている活性化関数を別の関数に置き換えることで、ニューラルネットワークの世界へ進むことができます。

では、ニューラルネットワークで使われている活性化関数を見ていきましょう。

様々な活性化関数

シグモイド関数

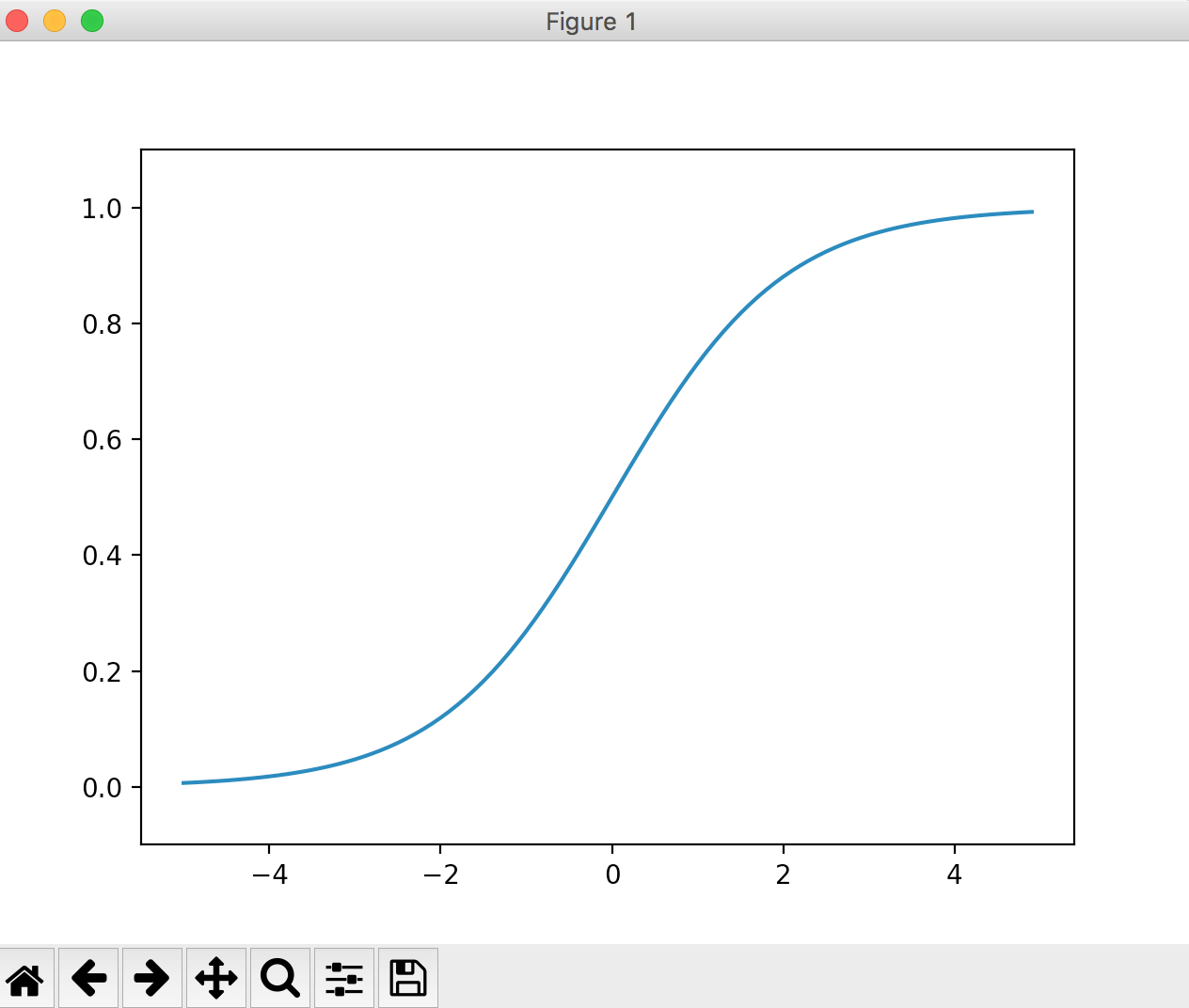

シグモイド関数はニューラルネットワークでよく使われる関数の一つです。

式は以下のようにあらわされます。

exp(-x)はeの-x乗という意味です。eはネイピア数で2.7182.......の実数です。

グラフは下図のような形になります。

ニューラルネットワークとパーセプトロンの主な違いは、この活性化関数だけです。

パーセプトロンはステップ関数、ニューラルネットワークはシグモイド関数など。

これだけなのです。

それではステップ関数とシグモイド関数を比較するためにグラフを重ねてみます。

この図をみて気づく点は、グラフの”滑らかさ”の違いだと思います。

シグモイド関数は入力に対して連続的(滑らかに)に変化していますが、ステップ関数は0を境にして急激に値が変化しています。

この違い、つまりシグモイド関数の滑らかさがニューラルネットワークの学習において重要な意味をもっています。

その理由は今後の記事で紹介していきます。

また、ステップ関数は1か0の値のみしか出力しませんが、シグモイド関数は0から1の間の実数(0.37469や0.98893など)を返します。

つまり、デジタル的な変化でなく、アナログ的な変化を含ませたわけです。

人間の脳はアナログの情報でやり取りしていますので、それに近づいたわけですね。

ステップ関数とシグモイド関数の共通点として、両者とも入力が小さいときほど小さい値を出力し、入力が大きい値ほど大きい値を出力しています。

つまり、重要な信号であれば大きな値を出力し、重要でない信号であれば小さな値を出力します。

また、出力の値は0から1の間のみだということもわかります。

ReLU関数

これまでに、活性化関数としてステップ関数とシグモイド関数を紹介しました。

シグモイド関数はニューラルネットワークの歴史において古くから使用されています。

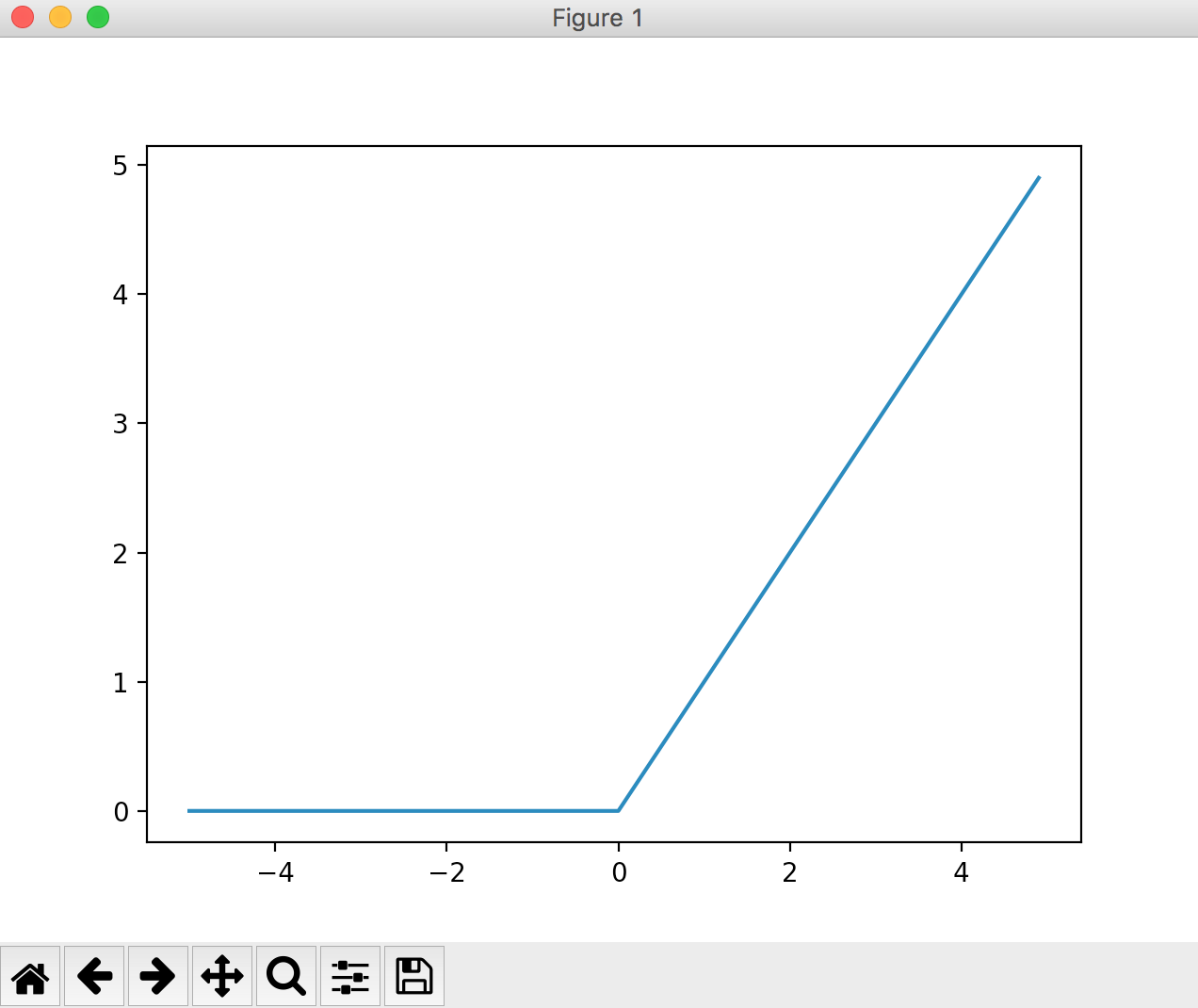

しかし、近年ではReLU (Rectified Linear Unit) 関数という活性化関数が主流となっているようです。

この関数は0を超えていれば入力の値をそのまま出力し、0を超えていない場合は0を出力するといった単純な関数です。

図で表すとこんな感じ。

式で表すとこんな感じ。

とても簡単な式ですね。

閾値以下の入力は0(重要でない)、閾値以上の入力は入力の値をそのまま出力、つまり重要度に比例した値を出力するといった機構ですね。

以上で活性化関数の説明は終わりです。

まとめ

今回は活性化関数について紹介していきました。

パーセプトロンの活性化関数はステップ関数であり、その活性化関数をステップ関数以外の関数に置き換えることにより、パーセプトロンをニューラルネットワークの世界に持っていけるということが分かりました。

ステップ関数以外の関数とは、シグモイド関数、ReLU関数などでした。

ではなぜ、シグモイド関数や、ReLU関数がニューラルネットワークに使用されるのか?

それは二つの関数にはステップ関数にはない”滑らかさ”があるからでした。

その”滑らかさ”が、ニューラルネットワークの得とする”学習”にとって非常に大切な意味を持ちます。

なぜなのか?

それについては今後のブログで書いていきますのでご安心を♪

ではでは。

続きの連載④はこちらです。

【ブログ一ヶ月目】2017年11月の収益&アクセス数報告

こんにちは、あつかんです。

今日で12月ということで、先月の収益&アクセス数を報告していこうと思います!

はい!皆様が大好きなお金に関する話ですw

実は、ブログ開設は今年の3月にしていたのですが、本格的に始めたのは今年の11月ですのでブログを始めてから一ヶ月目という目線でみていってください(; ・`д・´)

先月の目標として

・アクセス数:1000

・収益:まずはアドセンスの審査通過(通過したら100円以上)

を目標としておりました。

まずはアクセス数について述べていきます!

アクセス数

結論から申し上げますと、先月のアクセス数は2615でした!

第一の目標は達成( ;∀;)うれしい~~

ちなみに一番アクセス数を稼いだブログはこれでした。

近年トレンドの人工知能系のブログですね。

ホットなニュースを記事にしたら、ぷちバズが起こりました。

時事ネタ最高!

また、アクセス数の時系列データはこちら↓のような結果に。

ぷちバズを起こした記事は28日の21時頃に投稿していたので、やはり29日が盛り上がってますね。

あと、一回バズった記事は日がたってもアクセス数を稼いでくれます。

つまりバズ記事は残しておけば財産となるわけですね笑

アクセス元はというと、ほとんどがGoogle検索でした。

Google検索の結果、私のブログが検索の上位に反映されたってことですよね!

これはうれしいです!

てなわけで先月のアクセス数でした!

収益

先月の時点ではアドセンスが通ってなかったので、まずはアドセンス通過を目標に掲げてました。

結果は、、、、、

通過!!

いや~通過した時はうれしかったです。

それについて詳しくはこのブログに書いてあります。

11月21日に通過の結果がきたので、収益は21日~30日の10日間の収益となります。

ちなみに収益はアドセンスのみです。

収益の結果は、、、

牛丼大盛一杯くらい

です。

具体的な数値はGoogleさんに怒られそうなので控えました笑

一ヶ月目にしてはいいほうだと思っています。

てなわけで、収益に関しても目標は達成!

今月の目標

先月はブログの記事数を目標に設定していなかったので、今月はそれも組み込もうと思います。

・ブログ数:20記事

・アクセス数:3000

・収益:800円以上

が目標です!

がんばらねば~~~。

終わりに

今日もたくさんの読者様がこのブログに来てくれていることに感謝しています。

そのおかげで私はブログを続けられています。

ありがとうございます。

今後とも頑張っていきますので、よろしくお願いします。

また、最後まで読んでくださいまして、ありがとうございます。

もしよろしければ、読者登録していただけると大変励みになります。

よろしくお願いします。

では、あつかんでした!

【図解】ニューラルネットワークとは?【連載②】

どうも、あつかんです。

今回はニューラルネットワークについて述べていこうと思います。

ゼロから作るDeep Learningという本を参考にさせていただいております。

ニューラルネットワークについて述べるといっても、この記事ではすべては述べません。

全て述べると、本一冊書けちゃいますからねw

なので理解するにあたって必要最低限な知識を一歩一歩、順に複数のブログで連載形式で説明していきます。

遠回りのように見えますが、これが一番の近道だと思います。

まず、ニューラルネットワークを学ぶためにはパーセプトロンについての知識が必要です。

パーセプトロンについては下の記事にまとめてあります。

このブログは連載形式ですので、下の記事を読んでからこのブログを読むことをお勧めします。

ニューラルネットワークは簡単に言うとパーセプトロンの弱点を補ったものです。

では、パーセプトロンの弱点とはなにか。

それは、重みを設定する作業が人の手によって行われているという点です。

これは大変な作業であり、汎用性が生まれません。

このような弱点はニューラルネットワークによって解決できます。

具体的に言うと、適切な重みパラメータはデータから自動で学習できるという点です。

これがニューラルネットワークの重要な性質の一つになります。

では、その学習する方法を述べる前にまずはニューラルネットワークの概要について説明していこうとおもいます。

ニューラルネットワークの導入

ニューラルネットワークの例を図で表すと下の図のようになります。

入力層から始まって中間層(隠れ層)を経て出力層に伝わります。

ここで少しパーセプトロンの説明をします。

パーセプトロンは前のブログでも述べた通り、例として以下の図で表現できます。

パーセプトロンを数式で表すと以下のように表わせました。

b+x1w1+x2w2<=0の時

y=0

b+x1w1+x2w2>0の時

y=1

ここでbはバイアスパラメータといいます。

この値は任意で設定でき、ニューロンの発火のしやすさをコントロールできます。

w1、w2は各信号の重みを表わすパラメータであり、これは各信号の重要度をコントールできます。

しかし図にはbが定義されていません。

bを図に表わすと以下のような図になります。

ここで、パーセプトロンの式をシンプルな式に書き換えたいと思います。

y = h(b + x1w1 + w2x2)

h(a) = 0 (a <= 0)

h(a) = 1 (a > 0)

上記の式は

a= b + x1w1 + w2x2が0以下の時は

h(b + x1w1 + w2x2) = 0

つまりy = 0

a = b + x1w1 + w2x2が0を超過した時は

h(b + x1w1 + w2x2) = 1

つまりy = 1

ということを表わしています。

活性化関数h(a)について

いきなりh(a)が出てきて困惑したと思いますが、これは活性化関数と呼ばれるものです。

活性化関数は式の通り、入力の総和をどのように発火(活性化)させるかを決定します。

もう一度活性化関数の式を書きます。

a = b + x1w1 + x2w2

y = h(a)

aでは総和が計算され、aをh()の中にいれてyで出力するという機構になっています。

活性化関数を図の中に組み込むと以下のような感じ。

この図より、入力の重み付き信号の総和がaに入り、そしてaが活性化関数h()を通ってyに変換されていることが分かります。

活性化関数はここでは一つを紹介しましたが、実は複数存在します。

次のブログではどんな活性化関数があるのか?なぜ複数あるのか?について詳しく述べていこうと思います。

この段階ではニューラルネットワークについてまだ全然理解できていないと思いますが、まだ大丈夫です。

これから徐々に書いていきますので!

では!

次の連載はこちらです。

【図解】ディープラーニングの起源であるパーセプトロンとは?【連載①】

こんにちは。あつかんです。

近年話題の人工知能の一種であるDeep Learning。

理系の血が騒ぎ、これは勉強しなければならないという使命感にかられたため、現在、ゼロから作るDeep Learningという本を読んでいます。

学んだことの知識整理と情報共有のためにブログにまとめていこうと思います。

だれにでもわかるように書いているつもりです(; ・`д・´)

パーセプトロンとは?

パーセプトロンとは、ローゼンブラットというアメリカの研究者によって考案されたアルゴリズムです。

パーセプトロンはディープラーニングの起源となるアルゴリズムであるため、ディープラーニングを学ぶためにはパーセプトロンの仕組みを理解しなければなりません。

ここでは、パーセプトロンについて説明をしていこうと思います。

パーセプトロンは複数の信号である入力を受け取り、ある一つの信号を出力します。

信号とは「1」と「0」の二値です。

次に二つの信号を受け取り、一つの信号を出力するパーセプトロンのモデルを図で示します。

この図のx1とx2は入力、yは出力です。

w1とw2は重みを表しています。

〇がいわゆるニューロン(ノード)です。

入力信号はニューロンに送られた後に、それぞれの重みで乗算されます。

そして、送られてきた信号の総和を計算し、yとして計算します。

つまり、

y=x1w1+x2w2

となります。

そして、そのyが任意で設定した限界値(閾値)θを超えていた場合のみ1を出力します。

これを「ニューロンの発火」と呼びます。

これを式で表すと以下のようになります。

x1w1+x2w2<=θの時

y=0

x1w1+x2w2>θの時

y=1

一般的にはθ = -bと表され、以下のように上記の式を変形できます。

b+x1w1+x2w2<=0の時

y=0

b+x1w1+x2w2>0の時

y=1

bをバイアスパラメータといいます。

表現としてはどちらも等価です。

ここまでがパーセプトロンの基本です。

次は実際にパーセプトロンを使って簡単な問題を考えてみます。

パーセプトロンで論理回路を表現

ここでは、論地回路のANDゲートについて考えてみたいと思います。

ANDゲートというものは左図のように表わされ、皆さんのスマホの中に集積回路としてたくさん入っている電子回路です。

これをパーセプトロンで表現していきます!

ANDゲートは2入力1出力で二つの入力信号が1の時だけ1を出力し、それ以外は0を出力します。

入力に対する出力の関係表である真理値表を以下に示します。

| 入力 | 出力 | |

| x1 | x2 | y |

| 0 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 1 |

ここで、このANDゲートをパーセプトロンで表現していきたいと思います。

パーセプトロンのパラメータであるw1,w2,θの値を調整動作に基づき設定していきます。

例えば、適当に(w1, w2, θ) = (0.5, 0.5, 0.7)としたとしましょう。

入力が(x1, x2) = (0, 0)の時

x1w1 + x2w2 = 0*0.5 + 0*0.5 = 0 <= θ

となり総和が閾値を下回っているため0を出力します。

入力が(x1, x2) = (0, 1)の時

x1w1 + x2w2 = 0*0.5 + 1*0.5 = 0.5 <= θ

となり総和が閾値を下回っているため0を出力します。

入力が(x1, x2) = (1, 0)の時

x1w1 + x2w2 = 1*0.5 + 0*0.5 = 0 <= θ

となり総和が閾値を下回っているため0を出力します。

入力が(x1, x2) = (1, 1)の時

x1w1 + x2w2 = 1*0.5 + 1*0.5 = 1.0 > θ

となり総和が閾値を上回っているため1を出力します。

ちなみに Pythonで書くとこんな感じです。

# coding: utf-8 import numpy as np

def AND(x1, x2): x = np.array([x1, x2]) w = np.array([0.5, 0.5]) b = -0.7 tmp = np.sum(w*x) + b if tmp <= 0: return 0 else: return 1

if __name__ == '__main__': for xs in [(0, 0), (1, 0), (0, 1), (1, 1)]: y = AND(xs[0], xs[1]) print(str(xs) + " -> " + str(y))

このように(w1, w2, θ) = (0.5, 0.5, 0.7)と設定した場合は、真理値表通りの出力が得られたので、パーセプトロンでANDゲートを表現できたことになります。

また、(w1, w2, θ) の選び方は、無数に存在します。

例えば、(w1, w2, θ) = (0.59786, 0.3432425, 0.7123131)としても、ANDゲート同じ表現になります。

つまりパーセプトロンというのは、何か入力を与えたらこの入力に対する出力の判断をニューロンが行い応答するという作業をしています。

これはAIの得意とする画像認識の処理に似ています。

例えば、以下の画像のように猫の画像を入力したとします。

ニューロンは入力信号である猫の画像に対して何か判断を行います。

猫だと判断されれば、yで猫である確率が高いといった判断をします(かなり、強引ですが)。

そのためには、猫に対応する適切な重み(w1, w2, θ)を設定しなければなりません。

猫に対応する適切な重みは何か?

知りません笑

重みの設定方法について

では、(w1, w2, θ) はどのように設定するのか?という疑問がわくと思います。

重みはデータから学習させて設定させていきます。

パーセプトロンでは学習できません。

パーセプトロンをニューラルネットワークに拡張することによって学習できます。

ニューラルネットワークは、適切な重みパラメータをデータから自動で学習できるという性質を持っています。

次のブログではニューラルネットワークの基礎と、重みの学習について書いていこうと思います!

では!

次の連載はこちらです。

【AI】カプセルネットワークとは?【元論文あり】

どうも、あつかんです_φ( ̄ー ̄ )

本日以下のニュース記事を拝見しました。

これを見た瞬間、ニューラルネットワークを超えるものがとうとう出てきたか!Googleさんやべええええ!という印象をうけました。

Twitterでも様々な反応が。

ニューラルネットワークでさえできてないのにカプセルネットワークとか

— zeriiido (@zeriiiiiiiiiido) 2017年11月28日

カプセルネットワークってなんなんだろう、すごい可能性が高いって感じの理解しかできなかった

— 龍之介 (@spicyspyigo) 2017年11月28日

ニューラルネットワークはここ数年で、急速な発展を遂げ、Deep MindのAlpha Goは、囲碁で世界一の棋士に勝ち、IBMのWatsonは専門医でもできなかった白血病の型の特定までをもしています。

そして、そのニューラルネットワークよりも高い性能を示すカプセルネットワークというものが発表された。

いや〜徐々にシンギュラリティ―が近づいてますね~~。

ちなみにシンギュラリティーとは、人工知能が人間の能力を超え、人間の文明に計り知れない変化をもたらすという仮説のことです。

はやく、シンギュラリティー来ないかなw

元論文

カプセルネットワークについて調べたくなったので元論文を探したところ、ありました。↓

http://papers.nips.cc/paper/6975-dynamic-routing-between-capsules.pdf

とりあえず、アブストを日本語訳しておきますね。

------------------------------------------------------------------------------------

カプセルは、オブジェクトまたはオブジェクト部分などの特定のタイプのエンティティのインスタンス化パラメータを表すアクティビティベクトルを持つニューロンのグループです。

エンティティが存在する確率とインスタンス化パラメータを表す向きを表すために、アクティビティベクトルの長さを使用します。

あるレベルのアクティブなカプセルは、より高いレベルのカプセルのインスタンス化パラメータに対して、変換行列を介して予測を行います。

複数の予測が一致すると、より高いレベルのカプセルがアクティブになります。

我々は、識別可能に訓練された多層カプセルシステムが、MNISTにおいて最先端の性能を達成し、非常に重複する数字を認識する際に畳み込みネットよりもかなり優れていることを示す。

これらの結果を達成するために、我々は反復的なルーティング・アグリーメントメカニズムを使用します。

低レベルのカプセルは、低レベルのカプセルから来る予測を伴う大きなスカラ積を持つ高次のカプセルにその出力を送ることを好む。

------------------------------------------------------------------------------------

よくわからんな~~~

検索したら分かりやすい説明があった↓

つまり、カプセルの中にニューロンが詰められていて、そのカプセルで自己学習を促進していくと、従来法よりも良い結果が得られたわけですね。

カプセルネットワーク(CapsNet)のGitHubがあったので載せておきます。

.....なるほどわからん笑

YouTubeの解説動画

わかんなかったので、YouTubeで調べてみた。

ん~~~なんとなく。。。。

AIの専門家助けて(T ^ T)w

結局、なにがよくなったの?

従来法であるニューラルネットワークはあるモノを別の新しい視点から見ても同じものだと判断する作業はあまり得意ではないです。

例えば、ある猫がいたとして、猫の顔写真をみせたらニューラルネットワークは猫だと判断できました。

しかし、別視点から撮った猫の画像をニューラルネットワークに判別してもらうという作業をしてもらうと、良い結果は得られないということです。

人間であれば、猫の様々な別視点の画像をみたとしても、猫として認識できますよね。

それがカプセルネットワークだとできる。

カプセルネットワークでは、あるものを別視点から見た画像の情報の間を埋め、今までのニューラルネットワークでは難しかった新たな場面の判断を可能にするとのことだそう。

これってすごいですよね。

具体的な方法はよくわかんないから、勉強が必要だなー。

カプセルネットワークはディープラーニングが元になっているため、理解するためにはディープラーーニングの勉強が必要ですね。

ちなみに、ディープラーニングを勉強する際にオススメの本はこちらです。

【思考実験】終わりを思い描くことからはじめる【7つの習慣】

世界中でベストセラーとなっている本に「7つの習慣」があります。

今回はその本を読んでみて一番心に残った言葉を紹介していこうと思います。

心に残った言葉、、、、

それは、、、

終わりを思い描くことから始めるです。

わたしはこの言葉のおかげで、今自分が何をするべきかのヒントをもらえたと思います。

終わりとは?

終わりというのは自分の人生の終わりのことです。

つまり”死”です。

死が最終的なゴールになります。

思考実験

では、さっそくこのブログを読んでいただいているあなたも”終わりを思い描くことから始める”という思考実験をやってみましょう。

その方法を以下に具体的に示します。

精神的に少しきつい思考実験なので、あまり無理をせずにw

初めに、だれにも邪魔をされない一人ボッチの環境をつくってください。

TVなどの音がでる機器も消しましょう。

ではまずは、あなたの親しい方の葬儀に参列する場面を思い浮かべてみてください。

思い浮かべましたか?

では、次に行きましょう。

お線香をあげに、棺桶の前に行きます。

そして飾っている写真をふと見ました。

その写真に写っているのは、あなたでした。

そうです。これはあなたの葬式なのです。

葬式では、様々な人が弔辞を

述べます。

家族。

親戚。

友人。

仕事関係の人。

などなど・・・

ここで、よく考えてみましょう。

集まってくれた方に何と言ってほしいですか?

あなたの人生について、何を語ってもらいたいですか?

あなたはどんな風に見られたかったですか?

あなたは周りの人にどんな影響を及ぼしていたかったですか?

わたしだったら、「優しい人だった」「頼れるひとだった」「親孝行者だった」「

あなたのおかげで私の人生は良い方向に変わった」などという言葉をいわれたいです。

思考実験を終えて

さて、いまのあなたは『上記の問いに対する答えのような存在』になれていますか?

なれていなかったら、それになろうと努力していますか?

終わりを思い描くことで、目指すべきことの方向性が決まります。

その方向性を定めずに、適当に生きていたら様々な方向に発散している可能性があります。

これではゴールから遠ざかるばかりです。

大体の方向が決まってしまったら、それに向かって紆余曲折しながらもいずれかはその方向にあるゴールにたどり着きます。

今何をすべきかわからずに悩んでいる方がいたら、ぜひ終わりを思い描くことから始めるという作業をやってみましょう。

なにかのヒントを得られると思います。

それでは( `ー´)ノ

大学の研究室は社会の縮図?研究室生活の重要性について

こんにちは、あつかんです。

私は現在東京でバリバリ理系大学院生をしています。

研究分野はロボットの自律移動に関する研究です。

ちなみに修士2年です。来年就職。。。

就職先はみなさんが知っていると思われる大手企業です。

その就職先で修士1年のころにインターンシップをしてました!

インターンシップでは約一か月間働いてきました。

実際の社員さんと変わらないような業務を行いました。

いや~大変だったな( ;´Д`)

でもいい経験!

そして実際に働いてみてふと思いました。

研究室生活と社会人生活って意外と似通ってるな~。

研究室生活って超重要だな~と。

それらについて、具体的に学生目線で記していきたいと思います。

インターンシップ先で実際に働いてみて思った研究室との共通点

・研究

・毎週ミーティング

・成果が求められる

・事務的な作業

・上下関係

・プレゼン

・報告書作成

・勉強会

ここまでくると違いはなに?ってなると思います。

個人的に思った違いは抽象的ですけど、責任感と規模感くらいですかね。

ほかにも色々あると思いますがあくまでも個人的な意見です。。。

でも、その違いが結構大きいと思います。

この結果から、大学の研究室でやることは結局社会人になってもやるってことがわかりました。

つまり、研究室生活は重要。

社会人になる前に社会人の予行演習を行えるみたいな感じ。

次に研究室で培ってきた経験がなぜ重要かについて記していきます。

社会人になる前に役立ちそうな経験

毎週のミーティング

ミーティングの際に研究の進捗報告をしているんですけど、その時に教授に対して自分の意見がどのように説明したらうまく伝わるか?などを考えながらやっています。

時間の制約もあるので伝えたいことが多いときはしっかりまとめないといけません。

それが毎週ある。

毎週、結構な負荷がかかります。

でも、その負荷のおかげで成長はできていると思います。

プレゼン

研究成果がでると学会へいきます。そして自分の研究に関する分野や他分野の方も含めた人たちに対してプレゼンをします。

つまり、今回は教授相手にではなく全くの素人に対しても相手をしなければならない。

素人の方に複雑な研究の説明をし、理解させるのは相当難しいです。

しかし、何としてでも理解させなくてはならないんです!!

そこで、客観的な目線に立って資料を作るっていう能力が求められます。

それと、プレゼン資料作成スキルも求められます。

一枚のスライドにたくさんの文字を書いていては、情報量が多すぎてわかりづらいスライドになってしまいます。

簡潔にかつ重要な事項のみを記載し、他は言葉で補うといったことが求められます。

上記で述べた能力は研究室生活で鍛えられます。

上下関係

教授(研究室)=社長(会社)

先輩(研究室)=上司(会社)

後輩(研究室)=部下(会社)

といったような関係が研究室には存在します。

この点はまさに社会の縮図を表していますねw

つまり、すでに小さい会社で働いているようなイメージです。

社会人になる前に役立つ点は後輩に対して指導や面倒をできるってことだと思います。

自分はこの環境のおかげで、後輩に対して答えをすぐには教えずに少しヒントを与え、考えさせて答えを後輩自ら導き出させる重要性に気づきました。

このことにより、今後後輩が困難にぶつかったとしても、自ら壁を突破できる能力がつくからです。

すぐに答えを教えていては、その場しのぎですしね。

先のことを考えた結果、少し時間はかかりますが上記のような応用力は大切です。

最後に

このように、社会人になる前に社会人に必須なスキルは研究室で鍛えられます。

なんせ研究室は社会の縮図ですから( ゚Д゚)!

自分は研究室生活という貴重な経験をできているので、とても恵まれているな~~。(奨学金の返済がつらいけど、、、w)